L’intelligence artificielle open-source progresse rapidement, et la nouvelle famille Mistral 3 marque une étape importante. Avec ses modèles denses, multimodaux et open-source, elle permet d’utiliser une IA avancée directement sur son ordinateur, sans dépendre du cloud.

Dans ce tutoriel, nous allons voir comment installer et exécuter en local Mistral AI (le modèle Ministral 3 14B), le plus puissant des modèles conçus pour fonctionner sur une machine personnelle. Pour cela, nous utiliserons le logiciel LM Studio, simple d’utilisation et compatible avec la plupart des systèmes.

Ce guide convient aussi bien aux développeurs qu’aux utilisateurs souhaitant tester une IA moderne et performante en local.

1. Présentation du modèle Ministral 3 14B

Ministral 3 14B appartient à la gamme Ministral 3, pensée pour l’exécution locale. Ses caractéristiques principales :

-

14 milliards de paramètres

Capacité multimodale (compréhension texte + image)

-

Multilingue (plus de 40 langues, dont le français avec d’excellentes performances)

-

Très bon rapport coût/performance

-

Licence Apache 2.0, libre d’utilisation, y compris commercialement

Il rivalise avec des modèles bien plus grands tout en restant utilisable sur des PC équipés de 16 à 32 Go de RAM ou d’un GPU disposant de 8 à 12 Go de VRAM selon la version choisie.

2. Pré-requis pour installer Mistral 3 en local

Matériel recommandé

| Type | Minimum | Recommandé |

|---|---|---|

| CPU | Processeur moderne | Ryzen / Intel i7+ |

| RAM | 16 Go | start= »1764″ data-end= »1781″>32 Go ou plus |

| 6 à 8 Go de VRAM | 12 Go ou plus | |

| OS | Windows, macOS, Linux | — |

3. Télécharger et installer LM Studio

-

Aller sur : https://lmstudio.ai

-

Télécharger la version correspondant à votre système (Windows, macOS ou Linux).

-

Installer le logiciel.

-

Lancer LM Studio.

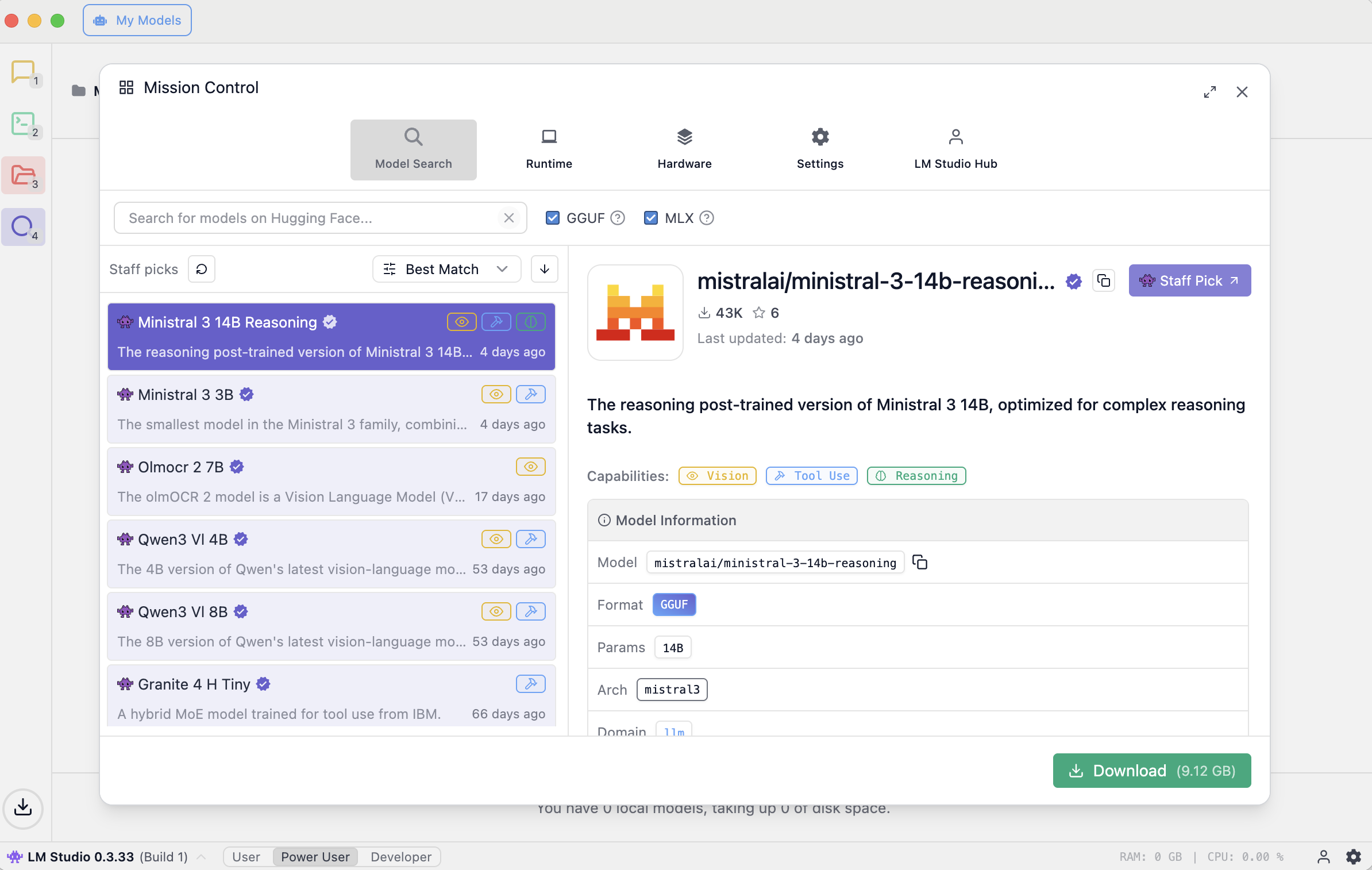

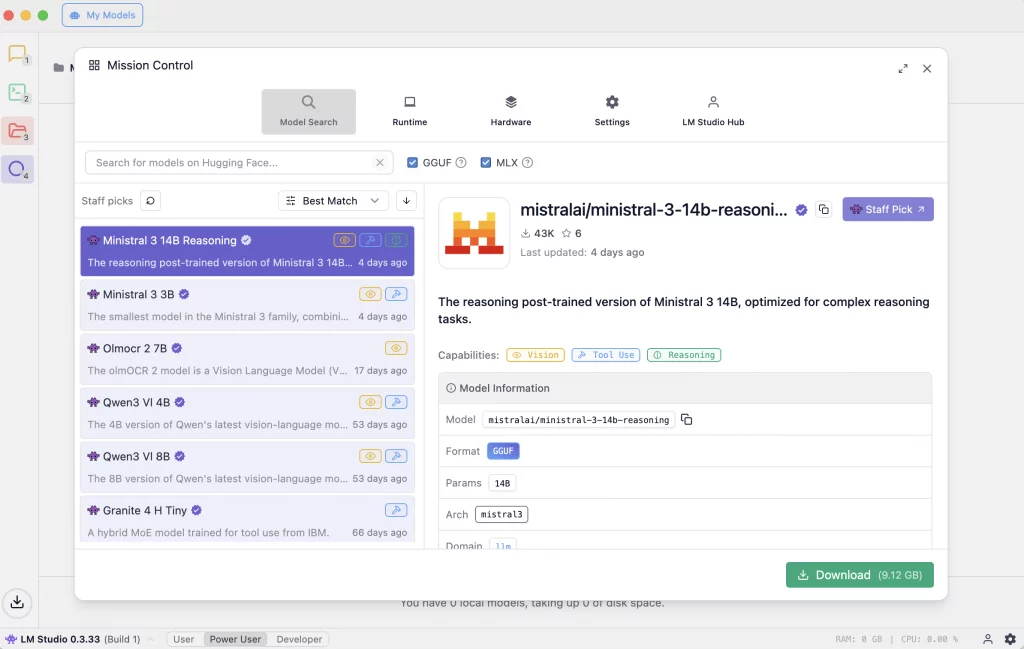

4. Télécharger Ministral 3 14B dans LM Studio

LM Studio propose un navigateur intégré permettant de récupérer facilement les modèles open-source.

-

Ouvrir l’onglet « Model » ou « Discover ».

-

Rechercher : Ministral 3 14B ou 3B (model plus petit)

-

Choisir la version souhaitée :

-

Ministral 3 14B Instruct pour un usage général

-

Ministral 3 14B Reasoning pour les tâches plus complexes

-

-

Sélectionner le format GGUF adapté à votre machine :

-

Q4_K_Mpour un bon équilibre -

Q5_K_Mpour une meilleure qualité -

Q3_K_Mpour les machines moins puissantes

-

-

Cliquer sur Download Model.

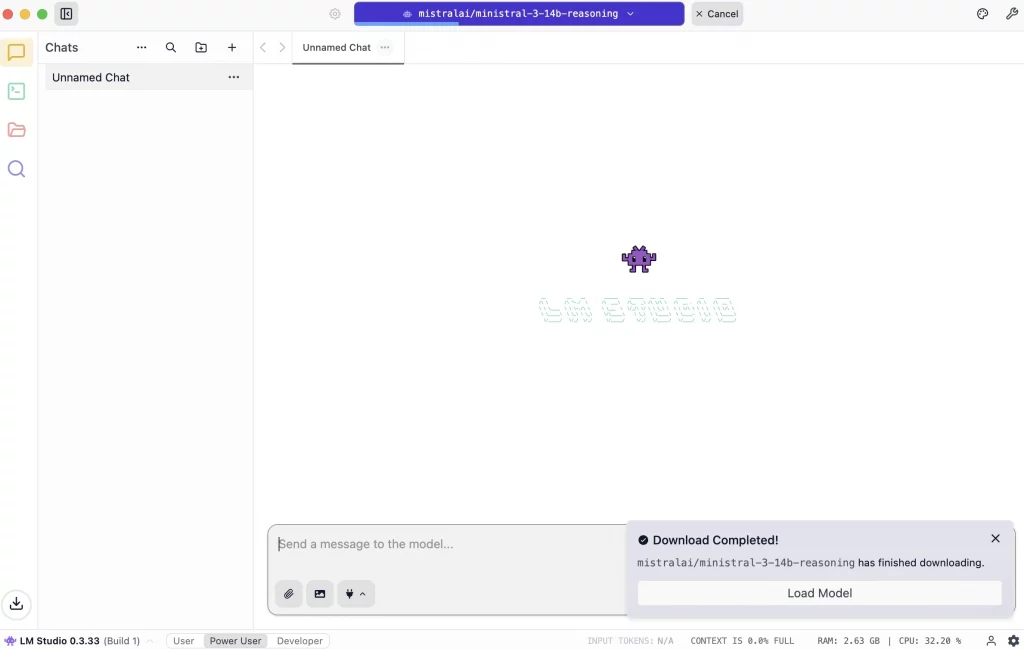

5. Charger et configurer le modèle

Une fois le modèle téléchargé :

-

Cliquer sur Open.

-

Vérifier les paramètres dans la colonne de droite :

| Paramètre | Recommandation |

|---|---|

| Context Window | 8192 tokens ou plus |

| GPU Offloading | Activer si un GPU est disponible |

| Max Tokens | 1024 à 2048 |

| Temperature | 0.7 pour usage général ; 0.2 pour le raisonnement |

7. Utiliser la compréhension d’images (multimodal)

Si vous avez téléchargé une version multimodale :

-

Cliquer sur l’icône d’importation d’image.

-

Ajouter l’image souhaitée.

-

Poser une question, par exemple :

« Décris ce que montre cette scène. »

8. Optimiser les performances

Avec un GPU

-

Activer le GPU Offloading

-

Tester différents niveaux selon la VRAM disponible

Sans GPU

-

Utiliser une quantisation légère (Q3 ou Q4)

-

Réduire la fenêtre de contexte

-

Fermer les applications lourdes

Conclusion

Utiliser un LLM en local revient à exécuter un modèle d’intelligence artificielle directement sur son propre ordinateur, sans passer par un serveur distant. Concrètement, le modèle — sous forme d’un fichier contenant des milliards de paramètres — est chargé en mémoire (RAM ou VRAM). Lorsqu’un utilisateur saisit une requête, l’ordinateur effectue lui-même l’ensemble des calculs nécessaires pour générer la réponse : analyses linguistiques, estimation des tokens suivants, traitement contextuel, et éventuellement compréhension d’images. La machine personnelle remplace donc l’infrastructure cloud habituellement fournie par les plateformes d’IA.

Dans ce fonctionnement local, tout repose sur deux facteurs :

-

La puissance matérielle de l’utilisateur (CPU, GPU, RAM).

-

L’optimisation du modèle</strong>, notamment via la quantisation, qui réduit la taille du fichier tout en préservant la qualité de génération.

C’est précisément sur ce point que les modèles Mistral se distinguent. La famille Ministral 3 a été conçue pour offrir un excellent équilibre entre performance et légèreté. Le modèle Ministral 3 14B tire parti de techniques d’optimisation avancées pour fonctionner efficacement sur des configurations grand public tout en conservant une qualité de génération très élevée, que ce soit en français, en anglais ou dans d’autres langues. Sa structure dense, associée à une phase de post-entraînement soignée, lui permet d’atteindre des résultats comparables à des modèles bien plus lourds. De plus, sa version multimodale ouvre la voie à des usages allant de la conversation classique à l’analyse d’images, le tout en local.

Avant de choisir un LLM local comme Mistral, il est utile d’en comprendre les avantages et les limites.

Avantages d’un LLM local

-

Confidentialité totale : aucune donnée ne quitte la machine.

-

Indépendance du cloud : pas besoin de connexion Internet, pas de dépendance à un service tiers.

-

Coût fixe : pas d’abonnement mensuel ni de facturation par token.

-

Réactivité : les réponses peuvent être très rapides si le matériel est performant.

-

Personnalisation totale : possibilité d’ajouter ses propres données, de fine-tuner ou de modifier le modèle.

Inconvénients d’un LLM local

-

Ressources matérielles nécessaires : certains modèles restent lourds et exigent un ordinateur performant (RAM/VRAM significative).

-

data-start= »2732″ data-end= »2758″>Performances variables : la vitesse et la qualité dépendent fortement de la machine, contrairement au cloud où la puissance est garantie.

-

Mise à jour manuelle : il faut installer les nouveaux modèles ou versions soi-même.

-

Fonctionnalités parfois limitées : certains très grands modèles ou fonctionnalités avancées ne peuvent pas (encore) être exécutés localement.

En définitive, Ministral 3 14B représente aujourd’hui l’une des meilleures options pour qui souhaite bénéficier d’une IA moderne, puissante, multilingue et totalement privée sur son propre ordinateur. Grâce à LM Studio, l’installation et l’utilisation deviennent accessibles à tous, tout en conservant les avantages majeurs d’un fonctionnement local.